L’intelligence artificielle transforme notre quotidien à une vitesse vertigineuse, mais comme toute révolution technologique, elle apporte son lot de dangers réels. Des deepfakes qui trompent des millions de personnes aux algorithmes qui discriminent sans qu’on s’en aperçoive, les risques de l’IA ne relèvent plus de la science-fiction.

En 2026, les principaux dangers de l’intelligence artificielle incluent l’utilisation malveillante, le biais algorithmique, et la perte d’emplois, entre autres.

Imaginez un monde où vous ne pouvez plus faire confiance à une vidéo, où votre candidature à un emploi est rejetée par un algorithme biaisé, ou où votre métier disparaît du jour au lendemain remplacé par une machine. Ces scénarios ne sont plus hypothétiques : ils arrivent déjà, maintenant, dans notre société.

L’IA ressemble à un couteau suisse ultra-performant : dans de bonnes mains, elle guérit des maladies, optimise l’énergie, et facilite notre vie quotidienne. Dans de mauvaises mains, elle peut manipuler l’opinion publique, discriminer massivement, ou éliminer des emplois sans créer d’alternatives. La différence réside dans la façon dont nous l’encadrons et l’utilisons.

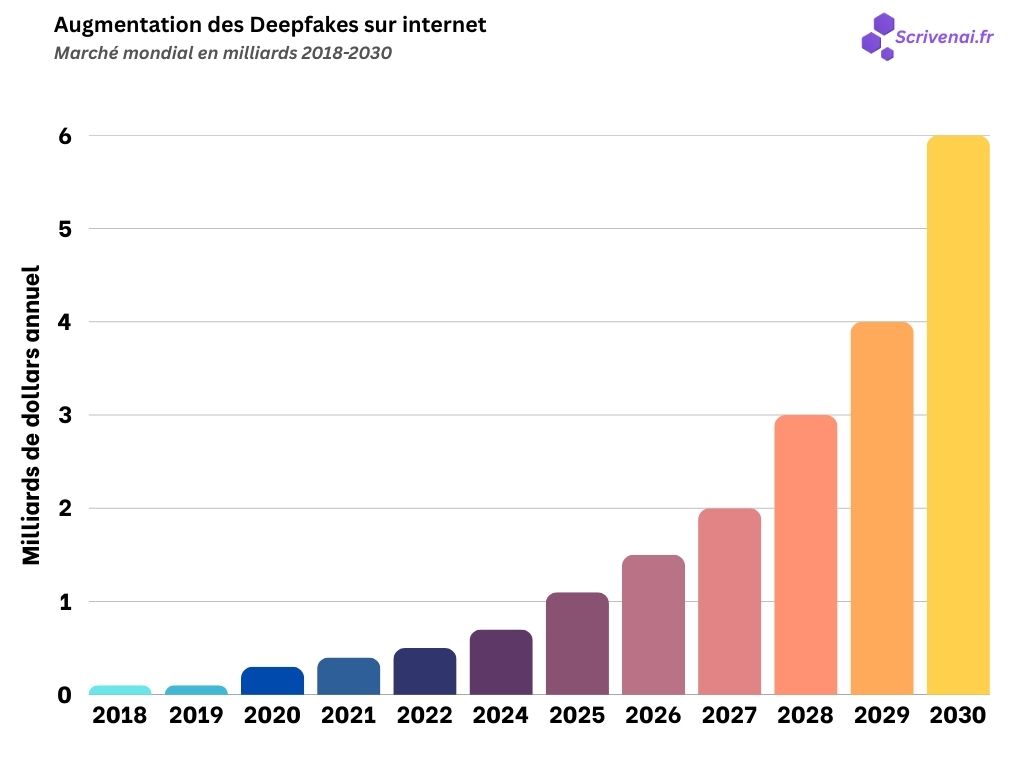

Contrairement aux risques technologiques du passé qui évoluaient lentement, l’IA progresse exponentiellement. Les deepfakes qui nécessitaient des studios hollywoodiens en 2020 se créent maintenant avec une simple application mobile. Les algorithmes qui analysaient quelques données personnelles accèdent désormais à l’intégralité de votre vie numérique.

L’enjeu n’est pas de stopper le progrès, mais de comprendre ces risques pour mieux s’en protéger et orienter le développement de l’IA vers un impact positif pour la société.

Dans cet article, vous découvrirez :

- Les 5 dangers majeurs de l’IA qui menacent notre société en 2026

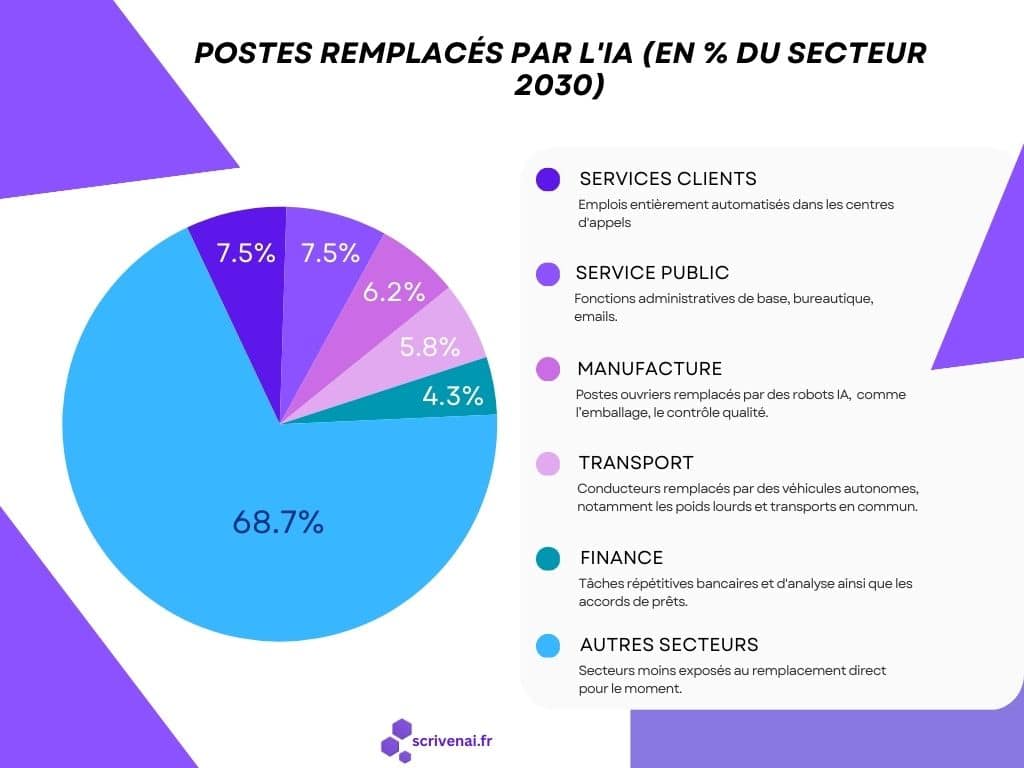

- L’impact réel sur l’emploi et les secteurs les plus vulnérables

- Les risques éthiques cachés dans nos algorithmes quotidiens

- Comment vous protéger concrètement de ces dangers

Comprendre les risques de l’IA aujourd’hui, c’est se donner les moyens de façonner un avenir où cette technologie nous sert plutôt qu’elle ne nous dessert.

Quels sont les dangers réels de l’intelligence artificielle en 2026

L’IA en 2026 ressemble à Internet dans les années 90 : un potentiel immense mais des risques sous-estimés qui émergent rapidement. Les dangers ne viennent plus des films de science-fiction, mais de votre quotidien : applications mobiles, réseaux sociaux, systèmes de recrutement, et même votre GPS.

Cyberattaques amplifiées par l’IA : la nouvelle génération de hackers

Les cybercriminels utilisent désormais l’IA comme un multiplicateur de force, automatisant des attaques qui nécessitaient auparavant des équipes entières. C’est comme passer d’un cambrioleur isolé à une organisation criminelle équipée des dernières technologies.

Phishing intelligent : L’IA analyse votre profil LinkedIn, vos publications Facebook, et vos habitudes d’achat pour créer des emails de phishing ultra-personnalisés. Au lieu du traditionnel « Bonjour », vous recevez un message mentionnant votre récent voyage à Barcelona avec le logo de votre vraie banque, créé automatiquement.

Attaques par déni de service évolutives : Les botnets pilotés par IA s’adaptent en temps réel aux défenses, comme un virus qui mute pour contourner les vaccins. Résultat : des sites e-commerce paralysés pendant les périodes de forte demande, avec des pertes chiffrées en millions d’euros.

Deepfakes : quand voir ne signifie plus croire

Qu’est-ce qu’un deepfake ? Cette technologie IA permet de créer de fausses vidéos ultra-réalistes où on peut faire dire ou faire n’importe quoi à n’importe qui. C’est comme un montage vidéo hollywoodien, mais automatisé : l’IA « apprend » le visage et la voix d’une personne grâce à des photos et vidéos existantes, puis génère de nouveaux contenus où cette personne semble authentiquement dire ou faire des choses qu’elle n’a jamais faites.

La technologie a franchi un cap critique en 2024-2025. Créer une vidéo convaincante d’un PDG annonçant la faillite de son entreprise ne demande plus qu’une heure et un smartphone récent. Plus besoin d’expertise technique : des applications grand public permettent de créer des deepfakes en quelques clics.

Impact sur les entreprises : En mars 2024, l’action d’une startup prometteuse a chuté de 60% suite à une vidéo deepfake montrant son fondateur avouer des pratiques frauduleuses. Bien que rapidement démentie, l’entreprise n’a jamais récupéré sa valorisation initiale.

Manipulation électorale : Les deepfakes de personnalités politiques se multiplient sur les réseaux sociaux, rendant la vérification des faits quasi impossible pour le citoyen moyen. C’est comme si n’importe qui pouvait créer un faux journal télévisé indétectable, mettant en scène des dirigeants tenant des propos qu’ils n’ont jamais tenus.

Biais algorithmiques : la discrimination invisible à grande échelle

Les algorithmes reproduisent et amplifient les biais humains, mais à une échelle et une vitesse industrielles. C’est comme avoir un recruteur discriminant qui traiterait 10 000 candidatures par heure sans supervision.

Recrutement biaisé : Amazon a dû abandonner son système de recrutement IA car il discriminait systématiquement les femmes, ayant appris sur un historique de CV majoritairement masculins. Des milliers d’entreprises utilisent encore des systèmes similaires sans s’en rendre compte.

Justice prédictive : Aux États-Unis, des algorithmes influencent les décisions de mise en liberté conditionnelle. Ces systèmes montrent des biais raciaux flagrants, condamnant davantage les minorités à des peines plus lourdes, perpétuant ainsi les inégalités du système judiciaire.

Crédit et assurance : Les algorithmes de scoring analysent vos données de géolocalisation, vos achats, et vos relations sociales pour évaluer votre solvabilité. Habiter dans un « mauvais » quartier ou fréquenter des personnes endettées peut automatiquement réduire votre score, créant des discriminations géographiques et sociales invisibles.

Fuites de données amplifiées par l’IA

L’IA traite des volumes de données personnelles sans précédent, créant des risques de fuites massives. Quand ces systèmes sont compromis, ce ne sont plus quelques milliers mais des centaines de millions de profils détaillés qui se retrouvent sur le dark web.

Cas récent : En 2024, la fuite de données d’un système IA de recommandations a exposé non seulement les achats de 50 millions d’utilisateurs, mais aussi leurs prédictions comportementales : tendances politiques, problèmes de santé supposés, et situation financière estimée. Des informations que les utilisateurs n’avaient jamais partagées explicitement.

Comment l’IA transforme-t-elle réellement l’emploi ?

L’impact de l’IA sur l’emploi ne se résume pas à une simple équation « robot = chômage ». La réalité est plus complexe : certains métiers disparaissent, d’autres évoluent, et de nouveaux émergent. Analysons concrètement quels secteurs subissent déjà ces transformations en 2026.

Secteurs en première ligne : automatisation massive en cours

Manufacturing et production : la révolution silencieuse

L’automatisation industrielle a franchi un nouveau cap avec l’IA. Tesla produit désormais une voiture toutes les 45 secondes avec 90% moins d’ouvriers qu’une chaîne traditionnelle. Les robots IA s’adaptent aux variations de production, réparent leurs propres dysfonctionnements, et optimisent les processus en temps réel.

Impact réel : 2.3 millions d’emplois industriels transformés ou supprimés depuis 2022 en Europe. Mais paradoxe : pénurie d’ingénieurs robotiques et de techniciens de maintenance IA.

Services clients : chatbots versus conseillers humains

Les centres d’appels traditionnels se vident progressivement. L’IA traite désormais 70% des demandes clients standard chez Orange, Bouygues, ou EDF. Ces systèmes comprennent les nuances émotionnelles, résolvent des problèmes complexes, et apprennent de chaque interaction.

Réalité terrain : 400 000 postes de téléconseillers menacés en France d’ici 2027, mais création de 50 000 emplois en analyse de données clients et supervision d’IA conversationnelle.

Finance et éducation : transformation en profondeur

| Secteur | Métiers menacés | Nouveaux métiers | Timeline |

|---|---|---|---|

| Finance | Analystes junior, conseillers bancaires | Spécialistes IA financière, éthiciens algorithmes | 2-5 ans |

| Éducation | Correcteurs, formateurs basiques | Designers pédagogiques IA, coachs d’apprentissage | 3-7 ans |

| Juridique | Assistants juridiques, recherche | Juristes en droit numérique, auditeurs IA | 5-10 ans |

La nuance nécessaire : évolution plutôt que disparition totale

L’IA ne supprime pas tous les emplois d’un secteur, mais transforme les rôles existants. Les radiologues ne disparaissent pas : ils supervisent des IA qui pré-analysent 90% des scanners, se concentrant sur les cas complexes et la relation patient.

Les comptables ne sont pas remplacés mais évoluent vers l’analyse stratégique, laissant l’IA gérer la saisie et les rapports automatisés. Résultat : moins de comptables « techniciens », plus de « conseillers financiers ».

Solutions concrètes pour accompagner cette transition

Formation continue et reconversion

Les gouvernements européens lancent des programmes de reconversion massifs. La France investit 15 milliards d’euros sur 5 ans pour former aux métiers de l’IA. Objectif : former 2 millions de personnes aux compétences numériques avancées d’ici 2027.

Compétences « IA-proof » à développer :

- Créativité et innovation stratégique

- Relations humaines complexes et empathie

- Résolution de problèmes non-standardisés

- Management et leadership adaptatif

Nouvelles opportunités émergentes

Pour chaque emploi supprimé, l’IA crée 0.7 emploi selon le McKinsey Global Institute. Ces nouveaux métiers demandent souvent moins d’années d’études mais plus de formation continue : prompt engineers, ethical AI specialists, human-AI collaboration managers.

La transition sera difficile pour certains secteurs, mais l’histoire montre que les révolutions technologiques créent finalement plus d’opportunités qu’elles n’en détruisent. L’enjeu réside dans l’accompagnement de cette transformation pour qu’elle bénéficie au plus grand nombre.

Comment encadrer l’IA pour limiter ses dangers ?

Face aux risques grandissants de l’IA, le monde ne peut plus se contenter de laisser-faire. Comme pour l’automobile au début du 20e siècle, il faut inventer le code de la route avant que les accidents se multiplient. Voici les solutions émergentes et leurs défis.

Régulation par niveau de risque : la hiérarchisation intelligente

Approche graduée selon les enjeux L’Union européenne pionière avec l’AI Act divise les systèmes IA en 4 catégories : risque minimal (recommandations Netflix), limité (chatbots), élevé (recrutement, crédit), et inacceptable (notation sociale). Plus le risque est élevé, plus les contraintes sont strictes.

Concrètement : votre IA de recommandations produits reste libre, mais votre algorithme de recrutement doit prouver sa non-discrimination avec des audits réguliers. Les systèmes de surveillance de masse sont purement interdits.

Défis d’application : Comment classer des systèmes hybrides ? Que faire des IA qui évoluent et changent de catégorie ? L’innovation rapide dépasse souvent la classification réglementaire.

Transparence et auditabilité obligatoires

Le « droit à l’explication » Les citoyens européens peuvent désormais demander pourquoi un algorithme les a pénalisés : refus de crédit, rejet de candidature, contrôle policier ciblé. Les entreprises doivent pouvoir expliquer la logique de leurs IA en langage compréhensible.

Certification et contrôles Comme les voitures passent le contrôle technique, les IA critiques subissent des audits de biais, sécurité, et performance. Des organismes indépendants testent leur fiabilité avant mise sur le marché.

Éducation et sensibilisation massive

Littératie IA du grand public Apprendre à détecter les deepfakes, comprendre les biais algorithmiques, connaître ses droits face à l’IA. C’est comme l’éducation routière : indispensable pour coexister avec la technologie.

Formation professionnelle Les développeurs, juristes, médecins, et managers doivent comprendre les implications éthiques de l’IA dans leur domaine. Objectif : éviter les dérives par ignorance.

Les obstacles à l’encadrement efficace

| Défi | Impact | Solutions testées |

|---|---|---|

| Innovation vs régulation | Ralentissement technologique | Bac à sable réglementaire |

| Juridictions multiples | Fragmentation des règles | Accords internationaux |

| Complexité technique | Incompréhension des législateurs | Expertise mixte public-privé |

| Vitesse d’évolution | Lois obsolètes dès publication | Régulation adaptative |

Coopération internationale : l’urgence d’un consensus

L’IA ne connaît pas les frontières Un deepfake créé en Russie peut déstabiliser les élections américaines. Une IA discriminante développée en Chine peut être utilisée en Europe. Seule une coordination mondiale peut encadrer efficacement ces technologies.

Initiatives prometteuses : Le Partnership on AI réunit Google, Meta, Microsoft pour définir des standards éthiques. L’OCDE développe des principes IA adoptés par 46 pays. Mais les géants technologiques gardent un pouvoir démesuré face aux régulateurs.

L’équilibre délicat : protéger sans étouffer

L’enjeu central : réguler assez pour protéger la société, mais pas trop pour préserver l’innovation. L’Europe mise sur la régulation stricte, les États-Unis privilégient l’autorégulation, la Chine contrôle étroitement. Qui trouvera le bon équilibre ?

La course est lancée entre ceux qui développent l’IA et ceux qui tentent de l’encadrer. L’avenir dépendra de notre capacité collective à inventer une gouvernance technologique à la hauteur des enjeux.

Conclusion

L’intelligence artificielle n’est ni le paradis technologique promis par ses promoteurs, ni l’apocalypse redoutée par ses détracteurs. C’est un outil puissant qui amplifie nos capacités humaines, mais aussi nos biais, erreurs, et intentions malveillantes.

Les dangers sont réels et présents : deepfakes qui manipulent l’opinion, algorithmes qui discriminent à grande échelle, systèmes autonomes qui échappent au contrôle humain, cybercriminalité amplifiée. Mais ces risques ne sont pas une fatalité. Ils peuvent être anticipés, encadrés, et minimisés par une gouvernance technologique adaptée.

L’enjeu crucial des prochaines années sera de trouver l’équilibre entre innovation et protection. Trop de régulation étouffera les bénéfices de l’IA, trop peu nous exposera à ses dérives. Cette responsabilité incombe autant aux développeurs qu’aux utilisateurs, aux entreprises qu’aux gouvernements, aux citoyens qu’aux décideurs.

Votre rôle dans cette transformation : rester informé, exiger la transparence des systèmes qui vous concernent, et participer au débat démocratique sur l’avenir que nous voulons construire avec l’IA. Car contrairement à ce que prétendent certains, l’IA n’est pas neutre : elle reflète les choix de société que nous faisons aujourd’hui.

Questions Fréquentes

Comment l’IA influence-t-elle nos choix quotidiens sans qu’on s’en aperçoive ?

L’IA façonne vos décisions par petites touches invisibles, s’appuyant sur des mécanismes psychologiques puissants. Les algorithmes de réseaux sociaux privilégient les contenus générant de fortes émotions, car les fausses informations se propagent 6 fois plus vite que la vérité. Cette influence est massive : aujourd’hui, 35 % des ventes d’Amazon et 75 % des contenus visionnés sur Netflix sont le résultat direct de recommandations algorithmiques. Spotify ou Instagram réduisent ainsi progressivement votre diversité d’écoute et d’opinion : près de 48 % des utilisateurs de plateformes de streaming constatent une standardisation de leurs goûts à cause de ces boucles de recommandation. La solution consiste à diversifier volontairement vos sources pour briser ces « bulles de filtres ».

Source : L’étude du MIT sur la propagation des nouvelles

Source : Rapport McKinsey sur le futur de la vente

Quels sont les dangers concrets des deepfakes pour la société ?

Les deepfakes créent une instabilité où « voir » ne signifie plus « croire ». Le danger n’est plus théorique : le volume de deepfakes détectés dans le monde a augmenté de 245 % en un an. En entreprise, l’impact financier est dévastateur ; en 2024, un employé a été trompé par une visioconférence truquée imitant son directeur financier, entraînant un virement frauduleux de 25 millions de dollars.

Au-delà de la finance, la menace est profondément humaine : le matériel pornographique représente environ 98 % des deepfakes en circulation, servant souvent d’outils de harcèlement. Quand tout peut être falsifié, les preuves authentiques perdent leur valeur. La réponse réside dans le déploiement massif d’outils de détection et une éducation critique du public.

Source : Rapport Sumsub sur la hausse des deepfakes en 2024

Source : Analyse du Parlement Européen sur les deepfakes

Comment les gouvernements peuvent-ils réellement contrôler l’IA face aux géants tech ?

Les gouvernements tentent de reprendre le contrôle, mais l’efficacité de leur action dépend de la coordination internationale. L’Europe mène la danse avec l’AI Act, entré en vigueur le 1er août 2024. Cette loi impose des amendes record pouvant atteindre 35 millions d’euros ou 7 % du chiffre d’affaires mondial pour les violations les plus graves. Elle interdit notamment les systèmes d’IA manipulant le comportement humain de manière subliminale.

Cependant, le défi reste temporel : alors qu’une loi met des années à être pleinement applicable (août 2026 pour l’AI Act), la technologie évolue à une vitesse exponentielle. Sans un consensus mondial, les régulations nationales risquent de rester de simples barrières locales face à une technologie par essence sans frontières.

Source : Texte officiel et explorateur de l’IA Act (UE)

Source : Calendrier de mise en œuvre de l’AI Act